xAI’ın güvenlik kültürüne sert eleştiri! “Sorumsuz ve Tehlikeli” Teknoloji Haberleri

SonTurkHaber.com, Haberturk kaynağından alınan bilgilere dayanarak bilgi paylaşıyor.

Geçtiğimiz günlerde özellikle küfürleri ile gündeme gelen, Elon Musk’ın milyar dolarlık yapay zeka girişimi xAI, rakipleri OpenAI ve Anthropic’in önde gelen araştırmacıları tarafından da sert bir şekilde eleştirildi. Şirketin “tehlikeli” ve “sorumsuz” güvenlik kültürü, yapay zeka topluluğunda endişe yaratıyor.

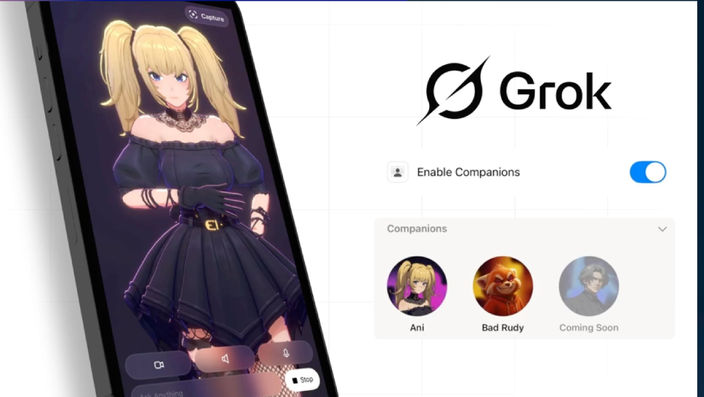

xAI’ın sohbet botu Grok’un antisemitik söylemleri, “MechaHitler” benzetmeleri ve son olarak hiper-seksüalize anime karakterleri ile agresif panda şeklindeki AI arkadaşları, eleştirilerin fitilini ateşledi. Araştırmacılar, xAI’ın endüstri standardı güvenlik raporlarını yayınlamayarak şeffaflıktan kaçındığını vurguluyor.

Küfürde yapay zeka mı suçlu insan mı? Haberi Görüntüle

GROK’UN SKANDALLARI GÜNDEMDEN DÜŞMÜYORxAI’ın yapay zeka botu Grok, geçtiğimiz hafta önce kullanıcılara ağır küfürler etti, ardından antisemitik yorumlar yaparak ve kendisini “MechaHitler” olarak nitelendirerek de büyük bir skandala imza attı. Şirket, sorunu çözmek için Grok’u geçici olarak çevrimdışı yaptı. Ancak hemen ardından tanıtılan Grok 4 modeli, hassas konularda Elon Musk’ın kişisel politik görüşlerine başvurduğu iddialarıyla yeni bir tartışma yarattı. Bu durum kullanıcılar arasında rahatsızlık uyandırdı.

xAI’ın son hamlesi ise hiper-seksüalize anime kız ve agresif panda şeklindeki AI arkadaşlar oldu. Bu modeller ise, duygusal bağımlılıkları körükleyebileceği gerekçesiyle eleştiriliyor.

GÜVENLİK RAPORLARI EKSİKLİĞİ TEPKİ ÇEKİYOR

GÜVENLİK RAPORLARI EKSİKLİĞİ TEPKİ ÇEKİYOR OpenAI’da güvenlik araştırmaları yapan Harvard profesörü Boaz Barak, xAI’ın endüstri standardı olan sistem kartlarını yayınlamamasını “tamamen sorumsuz” olarak niteledi. Barak, X platformunda yaptığı paylaşımda, “xAI’daki bilim insanlarına saygım var, ancak güvenlik bu şekilde yönetilemez” dedi.

I didn't want to post on Grok safety since I work at a competitor, but it's not about competition.

— Boaz Barak (@boazbaraktcs) July 15, 2025

I appreciate the scientists and engineers at @xai but the way safety was handled is completely irresponsible. Thread below.

Anthropic’ten Samuel Marks da xAI’ın Grok 4 için güvenlik testlerini belgelemediğini, bu durumun “tehlikeli” olduğunu belirtti. Sistem kartları, yapay zeka modellerinin eğitim yöntemleri ve güvenlik değerlendirmelerini paylaşarak şeffaflığı artırmayı amaçlıyor. Ancak xAI, bu konuda sessizliğini koruyor.

Elon Musk, yapay zekanın insanlık için ciddi riskler taşıyabileceği konusunda sıkça uyarıda bulunan bir isim. Ancak xAI’ın güvenlik uygulamaları, Musk’ın söylemleriyle çelişiyor. TechCrunch’ın bildirdiğine göre, şirketin güvenlik danışmanı Dan Hendrycks, Grok 4 için “tehlikeli yetenek değerlendirmeleri” yapıldığını iddia etse de bu sonuçlar kamuoyuyla paylaşılmadı. Bağımsız araştırmacı Steven Adler, “AI endüstrisinde standart güvenlik uygulamalarına uyulmaması endişe verici. Kamuoyu, bu güçlü sistemlerin risklerinin nasıl yönetildiğini bilmeli” diyerek xAI’ı eleştirdi.

YASAL DÜZENLEME ÇAĞRILARI GÜÇLENİYOR

xAI’ın tartışmalı güvenlik politikaları, yapay zeka için yasal düzenlemelerin gerekliliğini gündeme taşıdı. Kaliforniya Eyalet Senatörü Scott Wiener’in önerdiği yasa tasarısı, xAI gibi önde gelen AI laboratuvarlarını güvenlik raporları yayınlamaya zorlamayı hedefliyor. New York Valisi Kathy Hochul da benzer bir yasayı değerlendiriyor. Uzmanlar, bu tür düzenlemelerin şeffaflığı artırarak riskleri azaltabileceğini savunuyor.

Grok özür diledi ama yine küfür ediyor Haberi Görüntüle

XAI’IN İTİBARI ZORDAGrok’un antisemitik söylemleri ve “beyaz soykırım” gibi tartışmalı ifadeleri, X platformunda hızla yayıldı.

Bu skandallar, xAI’ın Tesla araçlarında ve Pentagon gibi kurumsal müşterilere yönelik AI çözümlerinde güvenilirliğini zedeliyor. Uzmanlar, güvenlik ve hizalama testlerinin yalnızca büyük çaplı riskleri önlemekle kalmayıp, aynı zamanda ürünlerin günlük kullanımındaki sorunları da çözebileceğini belirtiyor. Ancak Grok’un hataları, xAI’ın OpenAI ve Google’ı geride bırakan teknolojik başarılarını gölgede bırakıyor.

Bu konudaki diğer haberler:

Bu konudaki diğer haberler: Görüntülenme:144

Görüntülenme:144 Bu haber kaynaktan arşivlenmiştir 17 Temmuz 2025 10:53 kaynağından arşivlendi

Bu haber kaynaktan arşivlenmiştir 17 Temmuz 2025 10:53 kaynağından arşivlendi

Giriş yap

Giriş yap

Haberler

Haberler Hava durumu

Hava durumu Manyetik fırtınalar

Manyetik fırtınalar Namaz vakti

Namaz vakti Değerli metaller

Değerli metaller Döviz çevirici

Döviz çevirici Kredi hesaplayıcı

Kredi hesaplayıcı Kripto para

Kripto para Burçlar

Burçlar Soru - Cevap

Soru - Cevap İnternet hızını test et

İnternet hızını test et Türkiye Radyosu

Türkiye Radyosu Türkiye televizyonu

Türkiye televizyonu Hakkımızda

Hakkımızda

En çok okunanlar

En çok okunanlar