Sudoku yapay zekayı patlattı: Çözüyor ama nasıl çözdüğünü açıklayamıyor

SonTurkHaber.com, Haber Global kaynağından alınan verilere dayanarak açıklama yapıyor.

Ortaokul ya da lisede yazılı sınavda bir problemin cevabını kafanızda hesaplayıp cevabı kağıda yazdığınız olmuştur. Öğretmenler cevap doğru olsa bile cevaba nasıl ulaşıldığı yazılı kağıdında olmadığı için yanıtınızı genelde geçersiz sayarlar ve size o sorudan 0 puan verirler. İşte yapay zekanın başına gelen de tam olarak buydu...

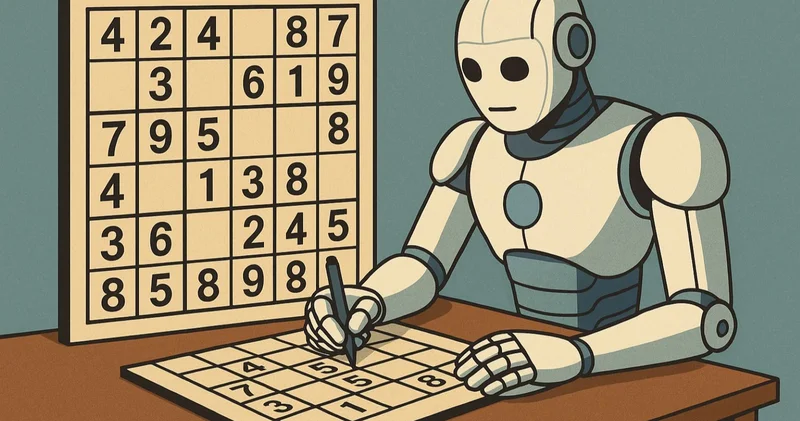

Metroda veya kahve molasında Sudoku çözmek önemsiz bir eğlence gibi görünebilir, ancak yapay zeka için bu basit bir oyundan çok daha fazlasıdır. Bir grup araştırmacı, bu sayısal bulmacayı yalnızca en gelişmiş dil modellerinin mantıksal yeteneğini ölçmek için değil, aynı zamanda çok daha önemli bir şeyi test etmek için de kullandı: Ne yaptıklarını ve neden yaptıklarını açıklama yeteneklerini.

Colorado Boulder Üniversitesi'ndeki bir bilim insanı ekibi, yakın zamanda yaptığı bir çalışmada, farklı yapay zekâ sistemlerini değerlendirmek için 2 binden fazla Sudoku bulmacası kullandı. Buldukları sonuç şaşırtıcıydı: Bazı modeller bulmacayı doğru bir şekilde tamamlayabildi, ancak neredeyse hiçbiri çözüme ulaşmak için attıkları adımları net bir şekilde açıklayamadı. Yapmak ve açıklamak arasındaki bu fark, özellikle tıbbi teşhis, finansal danışmanlık veya hukuki karar alma gibi hassas görevlerde kullanıldıklarında, güvenilir yapay zekâ tabanlı araçların geliştirilmesinde kritik bir sorun ortaya çıkarıyor.

Makine mantığını öğrenmek için SudokuBu deney için seçilen Sudoku bulmacaları klasik dokuza dokuz kareler değil, daha basit bir altıya altı versiyonuydu. Bu versiyon, ileri düzey matematik becerileri gerektirmeden belirli bir mantıksal karmaşıklığı koruyor. Orijinal makaleye göre, "Sudoku, adım adım problem çözmede dil modellerinin yeteneklerini incelemek için kontrollü bir ortam sağlıyor."

Araştırmacılar, her birinin benzersiz ve iyi tanımlanmış bir çözümü olmasını sağlayarak, farklı zorluk seviyelerinde 2 bin 293 Sudoku bulmacasından oluşan bir set tasarladılar. Bu bulmacalar, her bulmacanın çözülebilir olmasını garanti eden ve birden fazla geçerli cevaba izin vermeyen Z3 olarak bilinen resmi bir mantık sistemi kullanılarak oluşturuldu.

Bu özenli tasarım, yapay zeka hatalarının net bir şekilde izole edilmesini sağladı. Model bir hata yaparsa, birden fazla çözüm olmadığı ve yoruma yer olmadığı açıktı. Bu, sistemin oyun kurallarını ne kadar iyi anladığının net bir ölçüsünü sundu.

Bunu yapıyorlar... ama nasıl yaptıklarını açıklayamıyorlarTest edilen tüm modeller arasında, yalnızca OpenAI'nin 2023'te piyasaya sürülen gelişmiş bir sürümü olan "o1-preview" modeli, Sudoku bulmacalarının yaklaşık %65'ini doğru bir şekilde çözebildi. Buna karşılık, Llama ve Mistral gibi açık kaynaklı modeller, %1'in oldukça altında bir başarı oranıyla sembolik rakamlara zar zor ulaşabildi. Ancak en doğru model bile, cevaplarını gerekçelendirmeye çalışırken feci bir şekilde başarısız oldu .

Çözümlerini açıklaması istendiğinde, yapay zekanın performansı düştü. o1-preview tarafından sağlanan açıklamaların yalnızca %5'i insan değerlendiriciler tarafından haklı bulundu. Netlik açısından yalnızca %7,5'u olumlu puan aldı ve yanıtların eğitim değeri daha da düşüktü: Yalnızca %2,5'u çözüm stratejilerini öğrenmek için yararlı bulundu .

Çalışmanın yazarları bunu net bir ifadeyle özetliyor: "Bu araçlar potansiyel gösterse de [...] akıl yürütme adımlarını sadık ve anlaşılır bir şekilde sunmada hâlâ önemli zorluklarla karşı karşıyalar." Sonuçlar ile akıl yürütme arasındaki bu uçurum, mevcut dil modellerinin başlıca sınırlamalarından birini ortaya koyuyor: Doğru çözümleri taklit edebiliyorlar, ancak bunlara nasıl ulaştıklarını açıklayamıyorlar.

Haklı olmak ile akıl yürütmek arasındaki farkBu çalışmanın en ilginç yönlerinden biri, yapay zekaların doğru cevabı verip vermediğine değil, süreçleri hakkında tutarlı bir anlatı geliştirme becerilerine odaklanmış olması. Amaç, yalnızca kutuya doğru sayıyı koyup koyamayacaklarını görmek değil, çıkarımlar ve kurallara dayanarak neden bu sayıyı seçtiklerini anlamaktı .

Bu gereklilik, şans veya taklit yoluyla elde edilen doğru bir sonuç ile mantıksal bir düşünce süreci arasındaki farkı vurguluyor. Bilimsel makalenin ifadesiyle: "İyi akıl yürütenler, tümdengelim süreçlerini açıkça açıklayabilmelidir." İşte eksik olan tam da buydu.

Geçerli bir çözüm öneren ancak bunu açıklayamayan bir yapay zeka, kritik bağlamlarda güvenilir değildir. Sağlık, hukuk veya muhasebe gibi alanlarda, bir makinenin doğru bir cevap vermesi yeterli değildir. Kendini insanlara, ideal olarak açık, tutarlı ve anlaşılır bir şekilde kanıtlayabilmesi gerekir.

Titiz ve açıklayıcı bir deneyDeğerlendirme ekibi kendini öznel gözlemlerle sınırlamadı. Yapay zekanın yanıtlarını üç boyutta analiz eden bir uzman paneline başvurdular: Gerekçelendirme, açıklık ve eğitimsel değer. Bunu yapmak için, farklı zorluk seviyelerinde 20 seçilmiş Sudoku bulmacasına Likert tipi bir sistem (Evet, Belki, Hayır) uyguladılar.

Değerlendiriciler arası uyum analizi oldukça iyiydi; gerekçelendirme ve eğitimsel değer için 0,6, netlik için ise 0,4 Kappa değeri elde edildi. Bu, gözlemlenen eksikliklerin anekdotsal değil, sistematik olduğunu doğruladı. En gelişmiş yapay zeka bile karmaşık bulmacaları çözmeyi başardı, ancak açıklamaları insan filtresinden geçemedi ve çoğu durumda kafa karıştırıcı, yanlış veya tamamen saçmaydı.

Aslında, çalışmayı tartışan haberlerde ayrıntılı olarak açıklandığı gibi, yapay zekanın kavramları karıştırdığı, var olmayan kurallar öne sürdüğü, hatta ne söyleyeceğini bilemediği durumlarda hava durumu tahmininin bazı kısımlarını kullanarak yanıt verdiği tepkiler de vardı. Bu sapmalar, net bir mantığın olmadığı durumlarda, modellerin boşlukları görünüşte tutarlı, ancak orijinal görevle ilgisi olmayan herhangi bir içerikle doldurabileceğini gösteriyor.

Sudoku'dan Önemli KararlaraAnekdot gibi görünse de, çalışma sadece oyunlarla ilgili değil. Yazarlara göre, Sudoku bulmacalarını çözmek, karmaşık gerçek yaşam problemlerinin küçük ölçekli bir temsili işlevi görüyor. Net kurallar, adım adım akıl yürütme ve bilinçli karar verme gerektiriyor. Bu, örneğin vergileri yöneten, tıbbi kayıtları analiz eden veya yasal tavsiyelerde bulunan bir yapay zekadan beklenenle aynı.

Modellerin cevaplarına nasıl ulaştıklarını hâlâ net bir şekilde açıklayamaması, daha hassas görevlerdeki rolleri hakkında soruları gündeme getiriyor. Dolayısıyla, hukuk yüksek lisansı (LL.M.) programlarının doğal dilini biçimsel mantıksal yapılarla birleştiren "nörosembolik" sistemlere olan ilgi artıyor.

Çalışmaya göre, bu hibrit yaklaşımlar her iki dünyanın da en iyi yönlerinden yararlanabilir: Anlaşılır cevaplar üretme yeteneği ve geleneksel mantık sistemlerinin biçimsel titizliği.Yazarların açıkladığı gibi, "Modellerin bu açıklamaları uzman olmayan kullanıcılar için erişilebilir ve uygun ayrıntı düzeyleriyle yorumlayabilmesini umuyoruz."

Peki şimdi ne olacak?Araştırma, mevcut modellerin yapılandırılmış akıl yürütme açısından hâlâ kat etmesi gereken uzun bir yol olduğunu açıkça ortaya koyuyor. o1-preview gibi tescilli sistemler açık modellerden daha iyi performans gösterse de, hiçbiri yüksek etkili uygulamalar için gereken açıklayıcı güvenilirlik düzeyine ulaşamıyor .

Yazarlar, bu yolda ilerlemek için dil modellerini SMT çözücüler veya matematiksel ispat yardımcıları gibi biçimsel araçlarla entegre etmeyi öneriyorlar. Bu araçlar, ortalama bir okuyucu için pek kullanıcı dostu olmasa da, halihazırda son derece hassas akıl yürütmeye olanak sağlıyor. Mevcut modeller, bu karmaşık mantık ile doğal dil arasındaki boşluğu kapatabilirse, insan karar alma süreçleri için gerçek anlamda iş birliğine dayalı araçlar haline gelebilirler .

Bu arada, Sudoku bulmacalarından öğrendiğimiz şey değerli bir uyarı niteliğinde: İyi bir açıklamayla desteklenmeyen doğru bir cevap yeterli değildir. Bu noktada, yapay zekanın hâlâ geliştirebileceği çok şey var.

İlgili araştırmanın linki: "Bulmaca Çözümlerini Doğal Dilde Açıklamak:

6×6 Sudoku Üzerine Keşifsel Bir Çalışma"

Bu konudaki diğer haberler:

Bu konudaki diğer haberler: Görüntülenme:111

Görüntülenme:111 Bu haber kaynaktan arşivlenmiştir 30 Temmuz 2025 15:03 kaynağından arşivlendi

Bu haber kaynaktan arşivlenmiştir 30 Temmuz 2025 15:03 kaynağından arşivlendi

Giriş yap

Giriş yap

Haberler

Haberler Hava durumu

Hava durumu Manyetik fırtınalar

Manyetik fırtınalar Namaz vakti

Namaz vakti Değerli metaller

Değerli metaller Döviz çevirici

Döviz çevirici Kredi hesaplayıcı

Kredi hesaplayıcı Kripto para

Kripto para Burçlar

Burçlar Soru - Cevap

Soru - Cevap İnternet hızını test et

İnternet hızını test et Türkiye Radyosu

Türkiye Radyosu Türkiye televizyonu

Türkiye televizyonu Hakkımızda

Hakkımızda

En çok okunanlar

En çok okunanlar