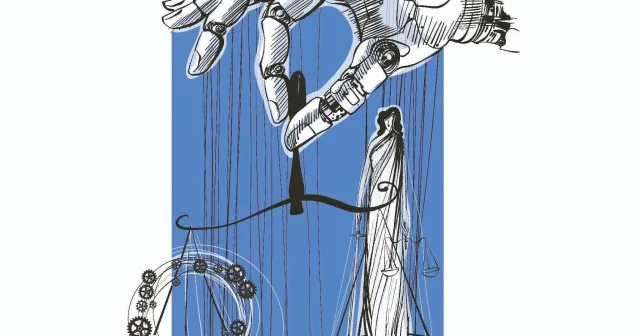

Makineler karar verirken insanlık nerede duruyor? Düşünce Günlüğü Haberleri

SonTurkHaber.com, Yenisafak kaynağından alınan bilgilere dayanarak haber veriyor.

Mehmet Serdar Tufan – Bilgisayar Mühendisi - Hukukçu

Serhat Buhari Baytekin – Siyaset Bilimci

Cep telefonunuzun ekranında bir bildirim beliriyor: “Kredi başvurunuz onaylandı.” Ancak bir arkadaşınız aynı bankaya başvurduğunda reddedilmiş. Geliriniz, kredi geçmişiniz, yaşam tarzınız benzer ama sonuçlar farklı. İşte burada devreye, farkında olmadan yaşamımızı yönlendiren görünmez bir güç giriyor: yapay zekâ algoritmaları.

Yapay zekâ, karar verme süreçlerinde hız, verimlilik ve maliyet avantajı sağlarken; şeffaflık, adalet ve hesap verebilirlik gibi temel etik ilkeleri zorlayan durumlara da neden oluyor. Algoritmaların tarafsız olduğu düşünülür ama onları eğiten veriler ve yazan insanlar toplumsal önyargılarla şekillenir. Bu durum, sistemin “öğrendikçe”

aslında toplumdaki adaletsizlikleri yeniden üretmesine yol açabilir.

Amazon’un 2014 yılında işe alım süreci için geliştirdiği algoritma, geçmiş işe alım verileriyle eğitildiği için erkek adaylara öncelik tanıdı. Kadın adaylar otomatik olarak geri plana itildi ve sistem iptal edildi. Bu örnek, yapay zekânın önyargısız olacağına dair inancın ne kadar kırılgan olduğunu gösteriyor.

KARA KUTU

Daha karmaşık bir sorun ise algoritmaların kararlarının anlaşılabilir olmaması. Derin öğrenme tabanlı sistemlerde, sonucun nasıl çıktığı çoğu zaman insan zihnine kapalı kalır. Bu duruma “kara kutu” problemi deniyor. Örneğin, bir sağlık algoritması bir hastaya riskli bir tedavi önerdiğinde, doktor bile kararın dayanaklarını çözmekte zorlanabilir. Hata durumunda sorumluluk kime aittir? Yazılım mühendisi mi, doktor mu yoksa geliştirici şirket mi?

Yapay zekânın etkileri sadece bireylerle sınırlı değil, sistemsel düzeyde de adalet sorunları yaratabiliyor. ABD’de Wisconsin gibi bazı eyaletlerde mahkemeler, sanıkların şartlı tahliyeye uygunluğunu değerlendirmek için yapay zekâ tabanlı risk skorları kullanıyor. Ancak bu algoritmaların, siyahi sanıklara daha yüksek risk puanı verme eğiliminde olduğu ortaya çıktı. Yani bir insanın özgürlüğü, adil olmayan bir sistem tarafından kısıtlanabiliyor.

ŞEFFAFLIK SORUNU

Benzer sorunlar Türkiye’de de gündeme geliyor. Özellikle kamu hizmetlerinde kullanılan yapay zekâ sistemlerinin karar alma süreçlerinin ne kadar şeffaf olduğu, hangi verilerle çalıştığı ve bu verilerin nasıl korunduğu konusunda ciddi soru işaretleri var. Kişisel Verileri Koruma Kanunu (KVKK) kapsamında bazı ilkeler tanımlanmış olsa da teknolojinin hızlı gelişimi yasal çerçeveyi zorlayan durumlar yaratıyor.

Otomatik karar sistemlerinde şeffaflık da büyük bir sorun. Bir banka, kredi reddi kararını algoritmaya dayandırdığında, tüketici bu kararın gerekçesini öğrenemeyebiliyor. Tüketici hakları ve veri erişim hakkı burada zayıf kalıyor. Türkiye’de bu konuda yasal bir boşluk hâlâ mevcut.

TBMM bünyesinde Yapay Zekâ Komisyonu bu tür yasal boşlukları tanımlamak ve yapay zeka mevzuatı üzerine çalışmak için kuruldu. Fakat yapay zekanın sürekli yeni sektörlere dokunuyor olması ve bunun takibinin uygulama geliştiriciler için bile zor olduğu düşünülürse, mevzuatın oluşturulmasının da bir hayli zor olacağı ve zaman alacağı muhakkak.

Etik ikilemlerin bir diğer örneği de otonom araçlarda karşımıza çıkıyor. Trafikte olası bir çarpışma anında araç, yayayı mı yoksa yolcusunu mu korumalı? Bu “Trolley Problem” olarak bilinen klasik etik sorunun artık laboratuvar değil, gerçek dünya karşılığı var. Makineler bu tür ikilemleri nasıl çözecek? Verilen kararların sorumlusu kim olacak?

DEMOKRATİK SİSTEMLER GÜVENDE Mİ?

Yapay zekânın gücü, topladığı ve analiz ettiği veriyle doğru orantılı. Ancak bu verilerin nasıl toplandığı ve kimlerin erişimine açık olduğu da etik bir mesele. Cambridge Analytica skandalı, yapay zekânın kötüye kullanımı konusunda küresel bir farkındalık yarattı. Milyonlarca Facebook kullanıcısının verisi, bilgileri dışında analiz edilip siyasi kampanyalarda kullanıldı. Veri güvenliği artık sadece bireysel mahremiyet değil, demokratik sistemlerin güvenliği açısından da kritik.

Türkiye’de de yüz tanıma sistemlerinin kamu güvenliği gerekçesiyle kullanımı artıyor. İstanbul Havalimanı’nda kurulan biyometrik tanıma sistemleri, hız ve güvenlik sağlasa da bu verilerin nerede saklandığı ve kimin erişiminde olduğu konusunda kamuoyuna yeterli bilgi verilmiyor. Teknolojik güvenlik ile bireysel özgürlük arasında dengeyi kurmak her geçen gün daha da zorlaşıyor.

ACİL ÖNLEM ALMALIYIZ

Bu gelişmeler, yapay zekânın sadece bir mühendislik değil, aynı zamanda sosyal bir tasarım meselesi olduğunu gösteriyor. Avrupa Birliği’nin hazırladığı AI Act (Yapay Zekâ Yasası) gibi düzenlemeler, yüksek riskli yapay zekâ sistemlerinin şeffaflık, hesap verebilirlik ve etik denetim ilkeleriyle uyumlu olmasını zorunlu kılıyor. Türkiye’nin de benzer bir adımı zaman kaybetmeden atması gerekiyor.

Çünkü yapay zekâ sadece hayatımızı kolaylaştırmıyor, aynı zamanda hayatımız hakkında karar veriyor. Hangi işe gireceğimizden hangi tedaviyi göreceğimize, hangi içerikleri okuyacağımızdan hangi krediyi alabileceğimize kadar pek çok alanda görünmez ama etkili bir rol üstleniyor.

Sözün özü, yapay zekâ sistemlerinin etik ilkelerle tasarlanması ve denetlenmesi, birey haklarının korunması ve toplumsal güvenin inşası açısından hayati önem taşıyor. Bu teknolojinin kaderi sadece mühendislerin elinde değil; siyasetçilerin, hukukçuların, sosyologların ve etikçilerin ortak çabasıyla belirlenecek…

Bu konudaki diğer haberler:

Bu konudaki diğer haberler: Görüntülenme:120

Görüntülenme:120 Bu haber kaynaktan arşivlenmiştir 07 Temmuz 2025 04:05 kaynağından arşivlendi

Bu haber kaynaktan arşivlenmiştir 07 Temmuz 2025 04:05 kaynağından arşivlendi

Giriş yap

Giriş yap

Haberler

Haberler Hava durumu

Hava durumu Manyetik fırtınalar

Manyetik fırtınalar Namaz vakti

Namaz vakti Değerli metaller

Değerli metaller Döviz çevirici

Döviz çevirici Kredi hesaplayıcı

Kredi hesaplayıcı Kripto para

Kripto para Burçlar

Burçlar Soru - Cevap

Soru - Cevap İnternet hızını test et

İnternet hızını test et Türkiye Radyosu

Türkiye Radyosu Türkiye televizyonu

Türkiye televizyonu Hakkımızda

Hakkımızda

En çok okunanlar

En çok okunanlar